Cos’è l’intelligenza artificiale?

L’intelligenza artificiale (spesso indicata con l’acronimo del termine inglese “Artificial Intelligence”: ‘AI’) non è un fenomeno nuovo, ma è solo di recente che è diventato un argomento di discussione per le sue applicazioni pratiche.

Meno di un decennio dopo aver aiutato le forze alleate a vincere la Seconda guerra mondiale decifrando il sistema di crittografia della macchina nazista Enigma, il matematico Alan Turing ha cambiato la storia una seconda volta ponendosi una semplice domanda: “Le macchine possono pensare?” L’articolo di Turing del 1950 “Computing Machinery and Intelligence” e la conseguente definizione e creazione del test di Turing stabilirono l’obiettivo fondamentale e la visione dell’AI.

Possiamo dire che l’intelligenza artificiale è la branca dell’informatica che mira a rispondere affermativamente alla domanda di Turing. È lo sforzo di replicare o simulare l’intelligenza umana nelle macchine. L’obiettivo dell’AI ha dato origine a molte domande e dibattiti. Tanto che nessuna definizione del campo è universalmente accettata. La mancanza di un accordo sulla definizione di intelligenza artificiale è dovuta anche al fatto che la tecnologia che può essere intesa sotto questo termine generico sta cambiando rapidamente.

Il principale limite nel definire l’AI semplicemente come “costruzione di macchine intelligenti” è che in realtà non spiega cos’è l’AI e cosa rende intelligente una macchina. L’intelligenza artificiale è una scienza interdisciplinare con molteplici approcci, ma i progressi nell’apprendimento automatico e nel deep learning stanno creando un cambio di paradigma praticamente in ogni settore dell’industria tecnologica. Tuttavia, recentemente sono stati proposti vari nuovi test che sono stati ampiamente ben accolti, tra cui un documento di ricerca del 2019 intitolato “On the Measure of Intelligence”. Nel documento, il ricercatore del deep learning e ingegnere di Google François Chollet sostiene che l’intelligenza è “la velocità con cui uno studente trasforma le sue precedenti esperienze in nuove abilità che richiedono adattamento”. In altre parole: i sistemi più intelligenti sono in grado di prendere solo una piccola quantità di esperienza e prevedere quale sarebbe il risultato in molte situazioni diverse. Nel frattempo, nel loro libro Artificial Intelligence: A Modern Approach, gli autori Stuart Russell e Peter Norvig affrontano il concetto di intelligenza artificiale focalizzando il loro lavoro sul tema degli agenti intelligenti nelle macchine. Con questo in mente, l’AI viene definita come “lo studio degli agenti che ricevono percezioni dall’ambiente ed eseguono azioni”.

Breve storia dell’intelligenza artificiale

Robot intelligenti ed esseri artificiali sono apparsi per la prima volta negli antichi miti greci, e lo sviluppo del sillogismo di Aristotele e il suo uso del ragionamento deduttivo è stato un momento chiave nella ricerca dell’umanità per comprendere la propria intelligenza. Sebbene le radici siano quindi estremamente profonde, la storia dell’AI come la pensiamo oggi abbraccia meno di un secolo. Quanto segue è un rapido excursus su alcuni degli eventi più importanti dell’AI.

1942.- Isaac Asimov pubblica le Tre Leggi della Robotica, un’idea che si trova comunemente nei media di fantascienza su come l’intelligenza artificiale non dovrebbe recare danno agli esseri umani. Poco dopo venne introdotta una Legge 0, che imponeva all’intelligenza artificiale di non recare danno all’umanità nel suo complesso (quindi, di poter eventualmente sacrificare un essere umano per il bene dell’umanità).

1943.- Warren McCullough e Walter Pitts pubblicano il documento “A Logical Calculus of Ideas Immanent in Nervous Activity“, che propone il primo modello matematico per la costruzione di una rete neurale.

1949.- Nel suo libro “The Organization of Behavior: A Neuropsychological Theory”, Donald Hebb propone la teoria secondo cui i percorsi neurali sono creati dalle esperienze e che le connessioni tra i neuroni diventano più forti quanto più frequentemente vengono utilizzate. L’apprendimento secondo i modelli di Hebb continua a essere un elemento importante nell’AI.

1950.- Alan Turing pubblica l’articolo “Computing Machinery and Intelligence”, proponendo quello che oggi è noto come Turing Test, un metodo per determinare se una macchina è intelligente.

1950.- Gli studenti universitari di Harvard Marvin Minsky e Dean Edmonds costruiscono SNARC, il primo computer a rete neurale.

1950.- Claude Shannon pubblica l’articolo “Programmazione di un computer per giocare a scacchi“.

1952.- Arthur Samuel sviluppa un programma di autoapprendimento per giocare a dama.

1954.- L’esperimento di traduzione automatica Georgetown-IBM traduce automaticamente 60 frasi russe, accuratamente selezionate, in inglese.

1956.- La definizione “Artificial Intelligence” è coniata al Dartmouth Summer Research Project on Artificial Intelligence. Guidata da John McCarthy, la conferenza è ampiamente considerata il luogo di nascita dell’AI.

1956.- Allen Newell e Herbert Simon dimostrano Logic Theorist (LT), il primo programma di ragionamento.

1958.- John McCarthy sviluppa il linguaggio di programmazione AI Lisp e pubblica “Programs with Common Sense“, un articolo che propone l’ipotetico Advice Taker, un sistema AI completo con la capacità di apprendere dall’esperienza con la stessa efficacia degli esseri umani.

1959.- Allen Newell, Herbert Simon e J.C. Shaw sviluppano il General Problem Solver (GPS), un programma progettato per imitare il meccanismo di risoluzione dei problemi tipico degli esseri umani.

1959.- Herbert Gelernter sviluppa il programma Geometry Theorem Prover.

1959.- Arthur Samuel conia il termine “apprendimento automatico” mentre era in IBM.

1959.- John McCarthy e Marvin Minsky fondano il MIT Artificial Intelligence Project.

1963.- John McCarthy avvia il laboratorio di intelligenza artificiale a Stanford.

1966.- Il rapporto del Comitato consultivo per l’elaborazione automatica del linguaggio (ALPAC) del governo degli Stati Uniti descrive in dettaglio la mancanza di progressi nella ricerca sulle traduzioni automatiche, un’importante iniziativa della Guerra Fredda che era orientata ad ottenere strumenti per la traduzione automatica e istantanea del russo. Il rapporto ALPAC porta alla cancellazione di tutti i progetti di MT finanziati dal governo.

1969.- I primi “sistemi esperti” di successo vengono sviluppati in DENDRAL, un programma XX, e viene creato a Stanford MYCIN, progettato per diagnosticare le infezioni del sangue.

1972.- Viene creato il linguaggio di programmazione logica PROLOG.

1973.- Il rapporto Lighthill, che descrive in dettaglio le delusioni nella ricerca sull’AI, viene pubblicato dal governo britannico e porta a gravi tagli ai finanziamenti per i progetti di intelligenza artificiale.

1974-1980.- La frustrazione per il mancato progresso dello sviluppo dell’AI porta a importanti tagli DARPA nelle borse di studio. In combinazione con il precedente rapporto ALPAC e il Rapporto Lighthill di quest’anno, i finanziamenti per l’intelligenza artificiale si esauriscono e la ricerca si blocca. Questo periodo è noto come il “primo inverno AI”.

1980.- Digital Equipment Corporations sviluppa R1 (noto anche come XCON), il primo sistema esperto commerciale di successo. Progettato per configurare gli ordini per nuovi sistemi informatici, R1 dà il via a un boom di investimenti in sistemi esperti che durerà per gran parte del decennio, ponendo effettivamente fine al primo AI Winter.

1982.- Il Ministero giapponese del commercio internazionale e dell’industria lancia l’ambizioso progetto dei sistemi informatici di quinta generazione. L’obiettivo di FGCS è sviluppare prestazioni simili a un supercomputer e una piattaforma per lo sviluppo dell’AI.

1983.- In risposta all’FGCS del Giappone, il governo degli Stati Uniti lancia la Strategic Computing Initiative per fornire ricerca finanziata dalla DARPA nell’informatica avanzata e nell’intelligenza artificiale.

1985.- Le aziende spendono più di un miliardo di dollari all’anno in sistemi esperti e un’intera industria nota come mercato delle macchine Lisp nasce per sostenerle. Aziende come Symbolics e Lisp Machines Inc. costruiscono computer specializzati per funzionare con il linguaggio di programmazione AI Lisp.

1987-1993.- Con il miglioramento della tecnologia informatica, sono emerse alternative più economiche e il mercato delle macchine Lisp è crollato nel 1987, inaugurando il “Secondo inverno AI”. Durante questo periodo, i sistemi esperti si sono rivelati troppo costosi da mantenere e aggiornare, finendo per cadere in disgrazia.

1991.- Le forze statunitensi schierano DART, uno strumento automatizzato di pianificazione e programmazione della logistica, durante la Guerra del Golfo.

1992.- Il Giappone termina il progetto FGCS, citando il fallimento nel raggiungere gli ambiziosi obiettivi proposti un decennio prima.

1993.- DARPA conclude la Strategic Computing Initiative nel 1993 dopo aver speso quasi 1 miliardo di dollari e aver disatteso le aspettative.

1997.- Deep Blue di IBM batte il campione mondiale di scacchi Gary Kasparov.

2005.- STANLEY, un’auto a guida autonoma, vince il DARPA Grand Challenge.

2005.- L’esercito americano inizia a investire in robot autonomi come “Big Dog” di Boston Dynamics e “PackBot” di iRobot.

2008.- Google fa progressi nel riconoscimento vocale e introduce la funzione nella sua app per iPhone.

2011.- Apple rilascia Siri, un assistente virtuale basato sull’intelligenza artificiale attraverso il suo sistema operativo iOS.

2012.- Andrew Ng, fondatore del progetto Google Brain Deep Learning, alimenta una rete neurale utilizzando algoritmi di deep learning e 10 milioni di video di YouTube come base informativa di partenza. La rete neurale ha imparato a riconoscere un gatto senza che gli venga detto precedentemente cosa sia un gatto (ma “imparandolo” nel corso dell’analisi dei dati a disposizione), inaugurando l’era della svolta per le reti neurali e il finanziamento del deep learning.

2014.- Google realizza la prima auto a guida autonoma in grado di superare un esame di guida.

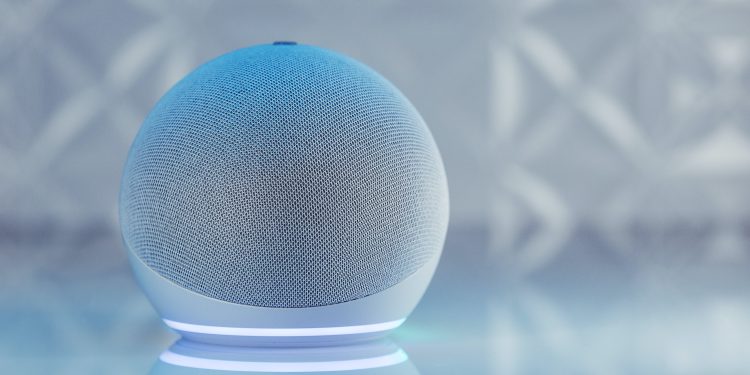

2014.- Viene rilasciato Alexa di Amazon, un dispositivo intelligente per la casa virtuale.

2016.- AlphaGo di Google DeepMind sconfigge il giocatore di Go campione del mondo Lee Sedol. La complessità dell’antico gioco cinese era stata vista come un grosso ostacolo da superare nello sviluppo dell’AI.

2016.- Il primo “cittadino robot”, un robot umanoide di nome Sophia, viene creato da Hanson Robotics ed è capace di riconoscimento facciale, comunicazione verbale ed espressione facciale.

2018.- Google rilascia il motore di elaborazione del linguaggio naturale BERT, riducendo le barriere nella traduzione e nella comprensione da parte delle applicazioni ML.

2018.- Waymo lancia il suo servizio Waymo One, consentendo agli utenti di tutta l’area metropolitana di Phoenix di richiedere il servizio di trasporto da parte di uno dei veicoli a guida autonoma dell’azienda.

2020.- Baidu fornisce il suo algoritmo LinearFold AI ai team scientifici e medici che lavorano per sviluppare un vaccino durante le prime fasi della pandemia SARS-CoV-2. L’algoritmo è in grado di prevedere la sequenza dell’RNA del virus in soli 27 secondi, 120 volte più veloce di altri metodi.

2020.- OpenAI (un’organizzazione non a scopo di lucro di ricerca sull’intelligenza artificiale) rilascia il modello di elaborazione del linguaggio naturale GPT-3, che è in grado di produrre testo modellato sul modo in cui le persone parlano e scrivono.

2021.- OpenAI si basa su GPT-3 per sviluppare DALL-E, che è in grado di creare immagini da prompt di testo.

2022.- Il National Institute of Standards and Technology rilascia la prima bozza del suo AI Risk Management Framework, guida degli Stati Uniti “per gestire meglio i rischi per individui, organizzazioni e società associati all’intelligenza artificiale”.

2022.- DeepMind (un’azienda inglese di intelligenza artificiale controllata da Alphabet, la casa madre di Google) lancia Gato, un sistema di intelligenza artificiale addestrato per eseguire centinaia di attività, tra cui giocare ad Atari, sottotitolare immagini, dialogare con umani, e utilizzare un braccio robotico per impilare blocchi di materiali vari.

E.P.